Medicina espacial, una estrategia para México: AEM

/La actividad humana en el espacio va en aumento y la medicina espacial representa una estrategia para que México pueda aportar científica y tecnológicamente en la planeación de vuelos espaciales tripulados por humanos, declaró para la Agencia Informativa Conacyt, el doctor Francisco Javier Mendieta Jiménez, director general de la Agencia Espacial Mexicana (AEM).

Entrevistado en el marco del Tercer Congreso Mexicano de Medicina Espacial, celebrado el 5 y 6 de octubre en la Universidad Popular Autónoma del Estado de Puebla (UPAEP), el funcionario dijo que la importancia de la medicina espacial radica en que a través de ella se estudia la adaptación y respuesta del ser humano y sus distintos órganos en ambientes espaciales donde hay microgravedad, además de exposición a radiación solar y cósmica.

“Debemos entender no solo el comportamiento del cuerpo humano en sus aspectos fisiológico, anatómico, psicológico y hasta social, sino también toda la materia biológica que va a servir para alimentar y coexistir en un ambiente espacial”, declaró el director de la AEM.

El doctor Mendieta Jiménez enfatizó que cada vez hay mayor interés no solo por parte de los gobiernos en todo el mundo sino también del sector privado por concretar los vuelos tripulados y la presencia del ser humano en Marte o nuevamente en la luna.

“No se trata de un asunto remoto o codicioso, es nuestro presente y así lo tenemos que asumir y México vive su momento para subirse a la temática de la medicina espacial, que es una prolongación de la salud aeronáutica”.

El funcionario de la AEM reconoció que México cuenta con instituciones y profesionales de alto perfil en el área de medicina aeroespacial, además de convenios que la AEM mantiene con agencias como la Administración Nacional de Aeronáutica y del Espacio (NASA, por sus siglas en inglés), la Agencia Espacial Europea, la Agencia Espacial Rusa, la Agencia India de Investigación Espacial e instituciones como la Administración Federal de Aviación (FAA, por sus siglas en inglés) de los Estados Unidos de América, entre otras.

La colonización en un futuro

El espacio representa en sí un recurso que todos los países quieren aprovechar en distintos ámbitos como la comunicación, obtención de imágenes satelitales para seguridad, fenómenos naturales, identificación de vectores de propagación de enfermedades, telemedicina y vuelo tripulado.

Para el director de la AEM, la presencia humana en el espacio se coloca como un tema relevante. Países como China, dijo, ya trabajan en vuelos aeroespaciales con sus primeros astronautas. El sector privado, por su parte, está cada vez más interesado en enviar seres humanos y no solo a orbitar la Tierra, pues observan el espacio como una prolongación de la navegación marítima y aérea.

“Marte tiene las condiciones para poder recibir un asentamiento humano y no muy lejos del futuro. El sector privado espera tener en el 2030 la primera presencia humana en Marte y en el 2050 lograr la primera colonización en hábitats confinados que tengan protección contra temperaturas extremas y rayos cósmicos, además de una atmósfera razonable para la supervivencia humana”.

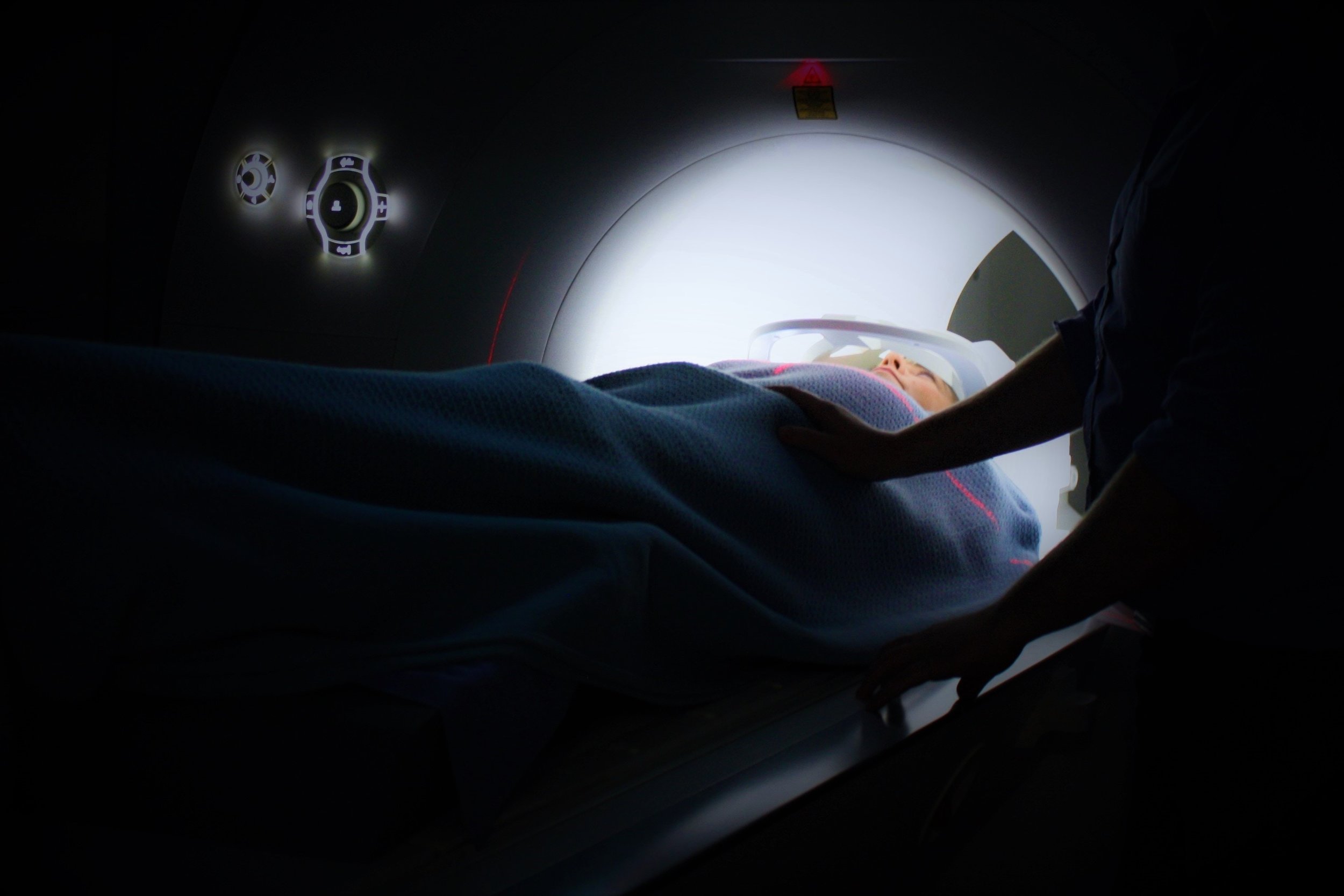

Toda esta planeación incluye el conocimiento del comportamiento del cuerpo humano en órbita terrestre, en viajes largos y espaciales y todo lo que tiene que ver con la comida, el agua, las actividades y todos los aspectos médicos, óseos y musculares; asimismo, se tiene que contemplar la presencia de enfermedades o emergencias, de ahí el interés de trabajar con la medicina espacial.

Participación de México

Actualmente, la AEM tiene proyectos en varias direcciones, uno de ellos, explicó su director general, es la prolongación de la medicina aeronáutica hacia la medicina espacial.

El doctor Mendieta Jiménez mencionó también que otro de los proyectos en que ya se trabaja es en el uso de información de imágenes espaciales para rastrear vectores de enfermedades, saber dónde están los transmisores, en qué zona del país, tomando en cuenta la estación del año, la humedad, temperatura y condiciones hidrometeorológicas.

“Otra línea de actividad es la astrobiología para saber cómo se comporta la materia viva en condiciones espaciales extremas y, por supuesto, tenemos grupos importantes de trabajo en el área de biología en Marte y la luna. Los grupos académicos en México están trabajando en estudios sobre la posibilidad de la existencia de bacterias fósiles en Marte, aunque esto hay que tomarlo con la precaución necesaria ya que la investigación aún está sujeta a comprobación experimental”.

Por último, el funcionario añadió que un cuarto proyecto es la telemedicina que sirve, entre otras cosas, para llevar servicios de salud a lugares donde no cuentan más que con lo básico, esto a través de análisis remotos.

Fuente: Conacyt